Dalam mereka kertas autoencoders untuk klasifikasi teks Hinton dan Salakhutdinov menunjukkan plot yang dihasilkan oleh 2-dimensi LSA (yang berkaitan erat dengan PCA):  .

.

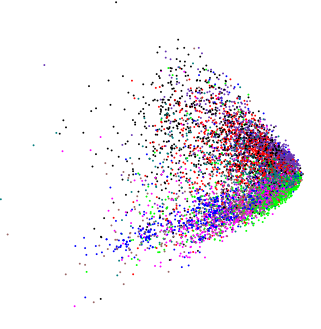

Menerapkan PCA ke data dimensi sedikit tinggi yang benar-benar berbeda, saya memperoleh plot yang mirip:  (kecuali dalam hal ini saya benar-benar ingin tahu apakah ada struktur internal).

(kecuali dalam hal ini saya benar-benar ingin tahu apakah ada struktur internal).

Jika kita memasukkan data acak ke PCA, kita mendapatkan gumpalan berbentuk disk, jadi bentuk ganjalan ini tidak acak. Apakah itu berarti sesuatu dengan sendirinya?

data-visualization

pca

macleginn

sumber

sumber

Jawaban:

Dengan asumsi variabel-variabelnya positif atau non-negatif, ujung-ujungnya hanyalah titik-titik di mana data akan menjadi 0 atau negatif. Karena data kehidupan nyata cenderung condong ke kanan, kami melihat kepadatan titik yang lebih besar di ujung bawah distribusi mereka dan karenanya kepadatan yang lebih besar di "titik" baji.

Secara lebih umum, PCA hanyalah rotasi data dan kendala pada data tersebut umumnya akan terlihat dalam komponen utama dengan cara yang sama seperti yang ditunjukkan dalam pertanyaan.

Berikut adalah contoh menggunakan beberapa variabel log-terdistribusi normal:

Tergantung pada rotasi yang tersirat oleh dua PC pertama, Anda mungkin melihat irisan atau Anda mungkin melihat versi yang agak berbeda, tunjukkan di sini dalam 3d menggunakan (

ordirgl()sebagai penggantiplot())Di sini, di 3d kita melihat beberapa paku yang menonjol dari massa tengah.

Untuk variabel acak Gaussian ( ) di mana masing-masing memiliki mean dan varians yang sama, kita melihat bola titikXi∼(N)(μ=0,σ=1)

Dan untuk variabel acak positif seragam kita melihat sebuah kubus

Perhatikan bahwa di sini, untuk ilustrasi saya menunjukkan seragam hanya menggunakan 3 variabel acak maka poin menggambarkan kubus di 3d. Dengan dimensi yang lebih tinggi / lebih banyak variabel, kita tidak dapat mewakili hypercube 5d dengan sempurna dalam 3d dan karenanya bentuk "kubus" yang berbeda agak terdistorsi. Masalah serupa mempengaruhi contoh-contoh lain yang ditunjukkan, tetapi masih mudah untuk melihat kendala dalam contoh-contoh itu.

Untuk data Anda, transformasi log variabel sebelum PCA akan menarik ekor dan merentangkan data rumpun, seperti halnya Anda mungkin menggunakan transformasi tersebut dalam regresi linier.

Bentuk lain dapat muncul di plot PCA; salah satu bentuk tersebut adalah artefak dari representasi metrik yang diawetkan dalam PCA dan dikenal sebagai tapal kuda . Untuk data dengan gradien panjang atau dominan (sampel disusun sepanjang dimensi tunggal dengan variabel meningkat dari 0 ke maksimum dan kemudian menurun lagi ke 0 sepanjang bagian data diketahui menghasilkan artefak tersebut. Pertimbangkan

yang menghasilkan tapal kuda yang ekstrem, di mana titik-titik di ujung sumbu menekuk kembali ke tengah.

sumber